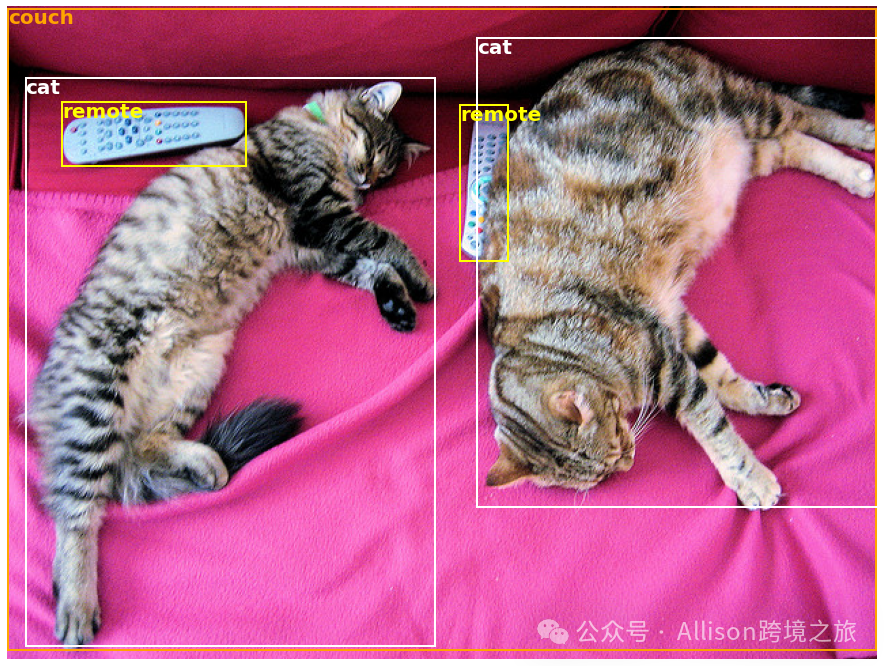

有粉絲留言說想利用AI挖掘開源信息,現在你看到的這類文章就是我利用AI抓取開源信息幫助我生成的文章,是的,我壓根看不懂一個代碼~如果你對這類AI自動化程序感興趣,可以看文末加入我的星球有3天試用,我晚點會把資料分享在里面,因為這個和跨境的日常工作不大,我就不錄視頻了,這個純屬我當初無聊學的,今天本來要錄制新視頻的,但是還在參加分享會議中,所以明天吧~周末學習不打烊~ 在當今的人工智能領域,各種神經網絡模型已經幫助我們解決了許多復雜的問題。但是,如果你能直接訪問數千種預訓練模型,應用到文本、圖像和音頻等多種領域,將會有多大的便利呢?今天,讓我們一同探索 Hugging Face 提供的開源項目——? Transformers,讓最新、最先進的機器學習技術觸手可及。 ? Transformers 提供數千種預訓練模型,這些模型可以應用于不同的模態(如文本、視覺和音頻),執行各種任務: 此外,Transformer 模型還支持 多模態任務,如從掃描文件中提取信息、視頻分類和視覺問答等。 為了讓用戶能夠最快速地使用這些強大的預訓練模型,? Transformers 提供了便捷的 API。例如,我們可以通過下列代碼快速實現情感分析: 該代碼會將預訓練模型下載并緩存,然后對輸入的文本進行評估,返回結果是“積極”的概率。 在自然語言處理(NLP)領域: 在計算機視覺領域: 在音頻領域: 此外,在多模態任務中: Hugging Face 提供的平臺無疑簡化了模型的使用過程,你可以輕松實現從數據預處理、模型訓練到推理等全過程。 例如,我們可以輕松實現圖像中的目標檢測: 運行上述代碼后,我們將會得到圖片中檢測到的目標以及它們的置信度分數和邊界框。如下圖所示,左邊是原始圖像,右邊是模型的預測結果: 在架構設計上,? Transformers 支持通過三大熱門深度學習庫——Jax、PyTorch 和 TensorFlow 無縫切換。不論你使用哪種框架進行模型訓練,都可以用另一種框架進行推理。這無疑極大地增加了靈活性和效率。 要想快速上手 ? Transformers 提供的預訓練模型,只需要幾行代碼: 對于 PyTorch: 對于 TensorFlow: 在這段代碼中,tokenizer 負責對輸入文本進行預處理,而 model 則接收處理后的輸入進行推理。 您可以通過以下命令安裝 Transformers: 或者選擇使用 conda: ? Transformers 需要 Python 3.8 以上版本,并且需要至少安裝 Flax、PyTorch 或 TensorFlow 其中之一。 Hugging Face 開發的 ? Transformers 項目為機器學習和深度學習領域帶來了便捷和高效。無論你是研究人員、開發人員,還是學生,都能夠利用這個工具箱輕松實現各種復雜任務。同時,豐富的預訓練模型庫為不同應用場景提供了強大的支持。 如果你正尋找一個可靠、易用并且功能強大的工具來加速你的機器學習項目,不妨嘗試一下 ? Transformers,相信你會有驚喜的發現。 希望這篇介紹能幫助你更好地了解 ? Transformers 的強大功能并開始你的機器學習之旅!

項目簡介

在文本任務中的應用

在圖像任務中的應用

在音頻任務中的應用

快速上手

from?transformers?import?pipeline

#?為情感分析準備一個流水線

classifier?=?pipeline('sentiment-analysis')

#?對輸入文本進行情感分析

classifier('We?are?very?happy?to?introduce?pipeline?to?the?transformers?repository.')

應用示例

更詳細的示例

import?requests

from?PIL?import?Image

from?transformers?import?pipeline

#?下載包含可愛貓咪的圖片

url?=?"https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

image_data?=?requests.get(url,?stream=True).raw

image?=?Image.open(image_data)

#?為目標檢測準備一個流水線

object_detector?=?pipeline('object-detection')

object_detector(image)

項目架構

from?transformers?import?AutoTokenizer,?AutoModel

tokenizer?=?AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

model?=?AutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs?=?tokenizer("Hello?world!",?return_tensors="pt")

outputs?=?model(**inputs)from?transformers?import?AutoTokenizer,?TFAutoModel

tokenizer?=?AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

model?=?TFAutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs?=?tokenizer("Hello?world!",?return_tensors="tf")

outputs?=?model(**inputs)

安裝指南

使用 pip 安裝

pip?install?transformers

使用 conda 安裝

conda?install?conda-forge::transformers

環境要求

總結

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)