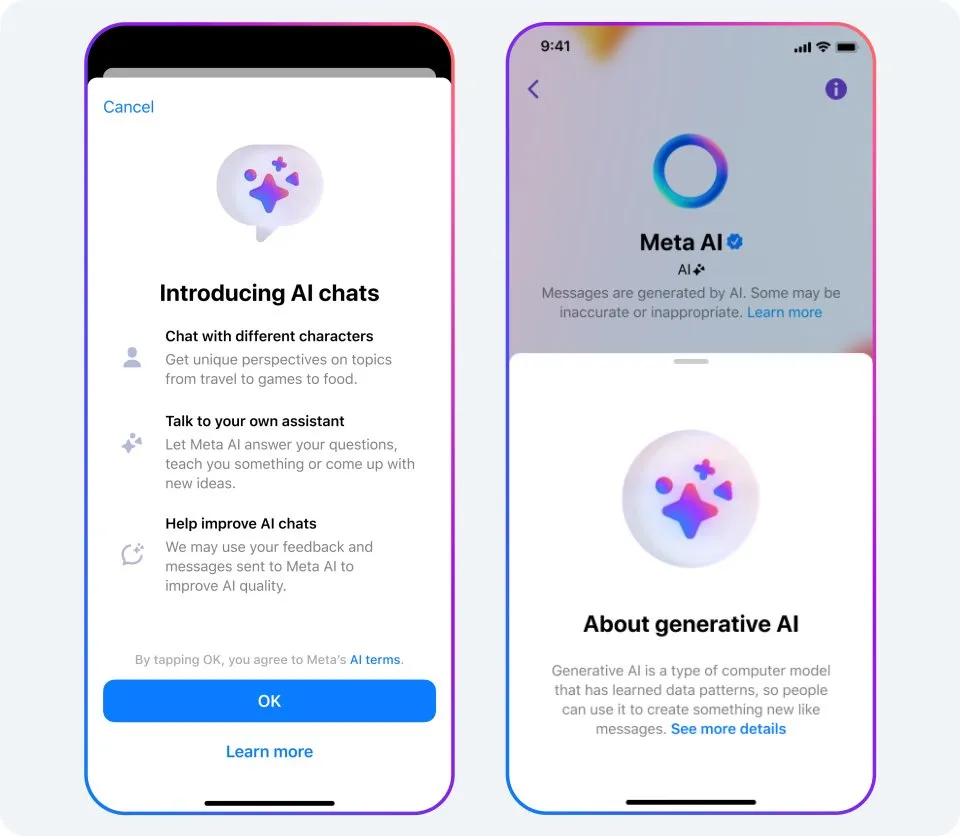

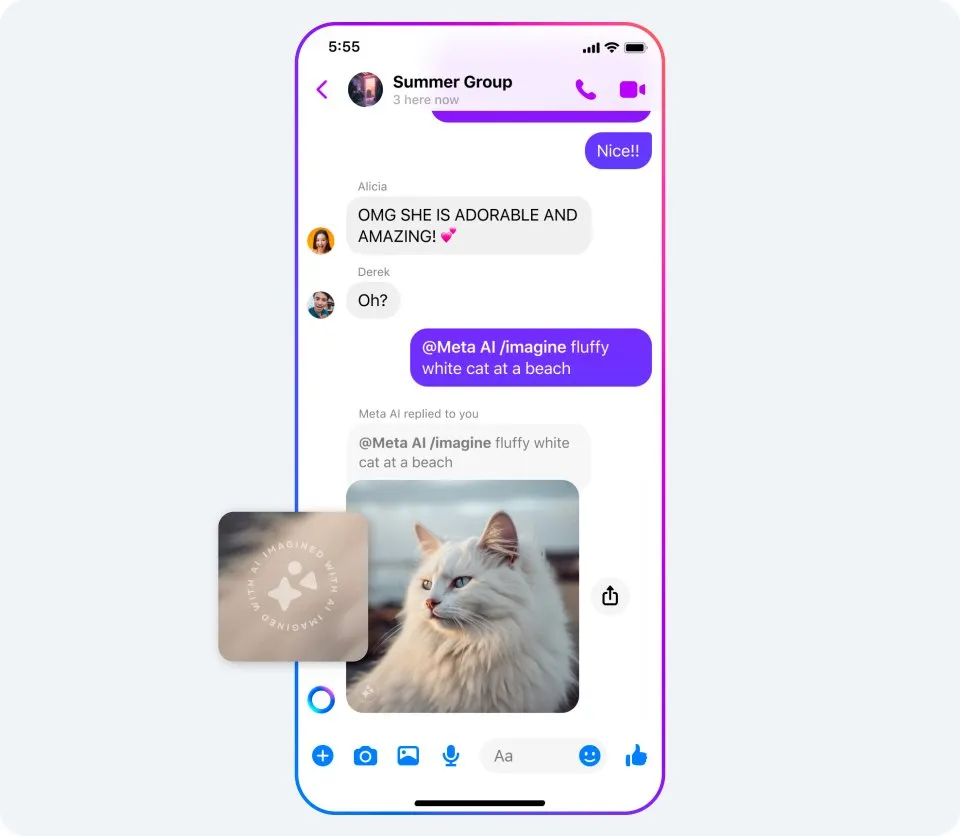

●??●??●? 要點 我們將在正式發(fā)布 AI 功能和模型之前為之構(gòu)建安全措施,以便用戶獲得更加安全愉悅的使用體驗。 與所有生成式 AI 系統(tǒng)一樣,這些模型可能返回不準確或不恰當?shù)妮敵鼋Y(jié)果。隨著這些功能逐步完善以及更多用戶分享反饋,我們將持續(xù)專注于功能改進。 我們正積極與全球政府機構(gòu)、其他公司、學(xué)術(shù)界和民間團體的 AI 專家、家長、隱私專家和倡導(dǎo)者等各方合作,共同建立負責任的監(jiān)管框架。 十多年來,Meta 一直是人工智能領(lǐng)域的開拓者。我們已面向研究人員發(fā)布了 1,000 多個 AI 模型、庫和數(shù)據(jù)集,其中包括與 Microsoft 合作推出的最新版大型語言模型 Llama 2。 在 Connect 2023 大會上,我們宣布了幾項全新生成式 AI 功能,用戶可借其在我們的平臺上獲得更具社交性和沉浸感的體驗。我們希望此類生成式 AI 工具能夠為用戶提供各種形式的支持。想象一下一群好友共同策劃旅行:他們可以在群聊中向 AI 助手詢問活動和餐廳推薦。再比如,教師可以利用 AI 助手來針對不同學(xué)生的學(xué)習(xí)風格制定個性化課程計劃。 開發(fā)這項技術(shù)意味著我們有責任制定最佳實踐和相關(guān)政策。盡管生成式 AI 有許多激動人心和富有創(chuàng)意的用例,但它并非總是完美無憾。例如,底層模型有可能生成虛構(gòu)的答案,或者放大其從訓(xùn)練數(shù)據(jù)中學(xué)習(xí)到的刻板觀念。我們將過去十年累積的經(jīng)驗融入到新功能中,比如推出提醒功能,讓用戶了解生成式 AI 的局限性;以及公正性分類技術(shù),以幫助我們發(fā)現(xiàn)和移除有風險的回復(fù)。這些功能的開發(fā)皆遵循了 Llama 2 負責任使用指南中概述的行業(yè)最佳實踐。 秉持負責任開發(fā)人工智能的原則,我們還對產(chǎn)品運行壓力測試以提高安全性能,并定期與國際政策制定者、學(xué)術(shù)界和民間團體的專家以及其他業(yè)內(nèi)同僚開展合作,共同推動這項技術(shù)的負責任使用。我們將逐步發(fā)布這些功能,并推出 Beta 測試版 AI 功能。我們將持續(xù)改進這些功能,根據(jù)技術(shù)發(fā)展和用戶的日常使用情況進行迭代優(yōu)化。 我們?nèi)绾呜撠熑蔚亻_發(fā)并將用戶安全放在首位? 我們開發(fā)的新型文本交互體驗(比如基于大型語言模型的 Meta AI 助手)由自定義 AI 模型提供支持,而這些模型是在 Llama 2 模型的基礎(chǔ)上構(gòu)建的,并充分利用了 Llama 2 模型在安全性和可靠性方面的訓(xùn)練成果。我們針對今天宣布的功能也開發(fā)了特定保護措施。 您可進一步詳細了解我們?yōu)樽R別潛在漏洞、降低風險、增強安全性和提升可靠性所采取的措施。例如: 通過紅隊 (Red Teaming) 演練攜手內(nèi)外部專家評估和改進我們的對話式人工智能。權(quán)威專家團隊耗費數(shù)千小時對這些模型進行壓力測試,檢測可能出現(xiàn)的意外使用方式以及識別和修復(fù)漏洞。 對模型進行微調(diào)優(yōu)化。這包括訓(xùn)練模型執(zhí)行特定任務(wù),例如生成優(yōu)質(zhì)圖像,并使用指令來增加其提供有幫助回應(yīng)的可能性。我們還訓(xùn)練模型,使其能夠針對安全問題提供得到專家支持的資源。例如,AI 會在回復(fù)某些醫(yī)療相關(guān)詢問時,推薦當?shù)氐男睦斫】岛惋嬍呈д{(diào)援助組織,同時明確表示無法提供專業(yè)醫(yī)療建議。 針對安全和負責任準則訓(xùn)練模型。通過對模型進行合規(guī)性訓(xùn)練,我們可以減少其在我們的應(yīng)用中分享可能對所有年齡段有害或不妥當?shù)幕貞?yīng)的可能性。 采取措施降低偏差。解決生成式 AI 系統(tǒng)的潛在偏差是一大新課題。與其他 AI 模型一樣,鼓勵更多用戶使用這些功能并分享反饋意見可以幫助我們改進方法。 開發(fā)新技術(shù)來檢測政策違規(guī)內(nèi)容并對其采取措施。我們的團隊構(gòu)建了算法,可實現(xiàn)在將有害回應(yīng)分享給用戶之前對其進行掃描和過濾。 在 AI 功能中內(nèi)置反饋工具。任何 AI 模型都并非完美無憾。我們將利用接收的反饋持續(xù)訓(xùn)練模型,以提高安全性能及自動檢測政策違規(guī)行為。我們還通過 Meta 長期運行的漏洞懸賞計劃向安全研究人員提供我們新開發(fā)的生成式 AI 功能。 我們?nèi)绾伪Wo用戶的隱私? 我們受到國際監(jiān)管機構(gòu)、政策制定者和專家的監(jiān)督,負有保護用戶隱私的責任。我們與之合作以確保我們開發(fā)的內(nèi)容遵循最佳實踐,并達到數(shù)據(jù)保護的嚴格標準。 我們認為讓用戶了解用來訓(xùn)練生成式 AI 產(chǎn)品所依托模型的數(shù)據(jù)類型非常重要。 我們?nèi)绾未_保用戶了解新功能的使用方法以及功能局限性? 我們會在功能內(nèi)提供信息說明,幫助用戶了解何時在與 AI 交互以及這項新技術(shù)的運作原理。我們會在產(chǎn)品體驗中指出,系統(tǒng)可能返回不準確或不恰當?shù)妮敵鼋Y(jié)果。 過去一年中,我們發(fā)布了 22 個“系統(tǒng)信息卡”,為用戶提供簡單易懂的信息,幫助其了解 AI 系統(tǒng)如何做出影響他們的決策。 如今,我們將在 Meta 的 AI 網(wǎng)站上推出新的生成式 AI 系統(tǒng)信息卡——其中包括為 Meta AI 提供文本生成支持的 AI 系統(tǒng)信息卡,以及為 AI 貼圖、Meta AI、加料和背景工具生成圖像的 AI 系統(tǒng)信息卡。這其中包含交互演示,以便用戶了解調(diào)整輸入提示對模型輸出結(jié)果的影響。 我們?nèi)绾螏椭脩襞袛喑鰣D像是由 AI 功能創(chuàng)建的? 我們的產(chǎn)品開發(fā)遵循行業(yè)最佳實踐,旨在防止用戶利用我們的工具傳播錯誤信息。通過 Meta AI、加料和背景工具創(chuàng)建或編輯的圖像將具有可見標記,以便用戶辨別出此類內(nèi)容由 AI 生成。此外,我們還努力開發(fā)其他技術(shù)以在 Meta AI 生成的圖像文件中嵌入信息,并計劃隨著技術(shù)改進將其應(yīng)用到其他體驗中。我們不計劃為 AI 貼圖添加這些功能,因為它們沒有那么逼真,因而不太可能被誤認作真實圖像。 目前,針對如何標識和標注 AI 生成式內(nèi)容,業(yè)界尚未建立任何統(tǒng)一標準。我們相信此舉意義重大,因而通過參與類似 Partnership on AI 的論壇與其他公司開展合作,希望共同制定這些標準。 我們采取哪些措施來阻止用戶使用生成式 AI 傳播錯誤信息? AI 在我們處理錯誤信息和其他有害內(nèi)容方面起到了關(guān)鍵作用。例如,我們開發(fā)了 AI 技術(shù),用于匹配與之前的事實核查內(nèi)容近乎重復(fù)的內(nèi)容。我們還設(shè)計了一款名為 Few-Shot Learner 的工具,這款工具靈活性更強,可快速針對新出現(xiàn)或不斷變化的有害內(nèi)容類型采取操作,并且支持 100 多種語言的使用場景。以前,我們需要收集數(shù)千甚至數(shù)百萬個示例以建立足夠龐大的數(shù)據(jù)集來訓(xùn)練 AI 模型,然后加以改進微調(diào)以使其正常運行,而 Few-Shot Learner 可以僅基于少數(shù)示例來訓(xùn)練 AI 模型。 與現(xiàn)有 AI 工具相比,生成式 AI 可以幫助我們更加快速準確地移除有害內(nèi)容。我們已開始測試大型語言模型 (LLM),針對社群守則對模型進行訓(xùn)練,使其幫助確定某條內(nèi)容是否違反我們的政策。這些初步測試表明,大型語言模型 (LLM) 在性能上優(yōu)于現(xiàn)有的機器學(xué)習(xí)模型,或者至少可對 Few-Shot Learner 這類模型起到增強作用,因此我們相信,生成式 AI 未來能夠幫助我們更好地執(zhí)行政策。 長按掃碼參加 【Meta 海外營銷秘笈?】小程序 免費課程 出海洞察,營銷工具,獨家活動 從電商、應(yīng)用到游戲行業(yè), 優(yōu)質(zhì)內(nèi)容,一網(wǎng)打盡!

文章為作者獨立觀點,不代表DLZ123立場。如有侵權(quán),請聯(lián)系我們。( 版權(quán)為作者所有,如需轉(zhuǎn)載,請聯(lián)系作者 )

網(wǎng)站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優(yōu)質(zhì)的學(xué)習(xí)資料。

現(xiàn)在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)