前幾天我的文章中有寫網站收錄不斷掉的問題,尤其是小語種的信息收錄不斷的掉,所以這周就打算花點時間來測試下小語種翻譯的精準度這件事情。這篇文章就簡單說下我的思路,以及數據驗證的一些方法。

之前我的那個小語種網站,是在英語版本上進行翻譯的。且使用的是插件方案,也就是做好英語版本后,使用小語種插件的自帶翻譯功能,將英語版本翻譯成各自的小語種版本。

然后我周末花了點時間仔細研究了那個插件的翻譯機制,發(fā)現這款插件使用的是谷歌翻譯的 API,將網頁內容翻譯完成后再填充到頁面的。

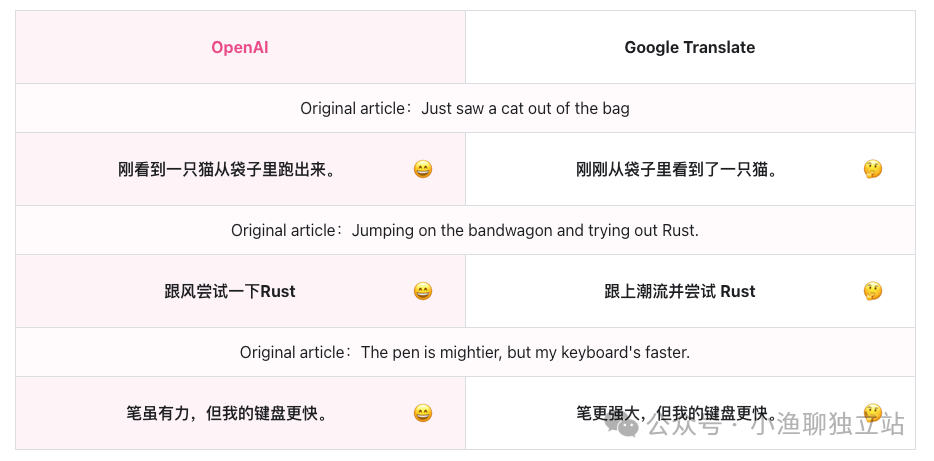

這就有點不妙了,畢竟谷歌翻譯的內容質量還是有待商榷的。比如上圖這個案例,谷歌翻譯在很多語句的細節(jié)上做不到「信雅達」,它只是生硬的將英文翻譯成中文而已。

所以昨天就干脆將全部的小語種全部刪了,不破不立嘛。然后打算自己通過身份設定來訓練下 Prompt,從而再將其運用到自己的小語種網站上面。

但問題也就出來了,我現在好像還沒有找到一款合適的能集成 OpenAI 的小語種插件。也就是說,后續(xù)的小語種的翻譯工作,我都需要自己手動去完成。

當然,看到這里肯定會有朋友說,要不要試試 DeepL,這個比谷歌翻譯強很多的翻譯軟件。

其實這個方案我昨天晚上就已經試過了,總體來講翻譯的效果要比谷歌翻譯好太多了,但是有個問題不得不承認,就是真的太貴了。

我昨天晚上申請了 Pro 版本 API,并將其整合到自己的網站上。試用沒問題后,大約翻譯了 40 多個頁面吧(翻譯成法語),就消耗了 60 多萬次字符了,計費賬單就顯示需要支付 17 美金。

當時看到那個賬單真的有點不敢相信,畢竟我的網站現在有 150 多個頁面,就法語這個單一站點而言,全部翻譯完可能就需要 60 美金左右。試想我要是做 10 個小語種版本呢,成本不得 600 美金?

所以后續(xù)我還是想以 OpenAI API 為主,通過將網頁上的內容整理好,并利用訓練好的 Prompt,得到自己想要的小語種數據。等數據勘驗無誤后,再手動整理到小語種版本上去。

當然,這套方法我現在還沒玩熟,所以先手動操作來熟悉下整個流程,看看過程中會犯哪些錯誤,并踩踩其中的一些坑。等后續(xù)操作熟練后,再來看看能不能有什么自動化的方案。

現在初步的設想是,利用爬蟲將網站源數據抓取下來,并分門別類整理到表格中。等這個過程完成后,再去使用 OpenAI API 的數據處理能力,將文本翻譯成對應的小語種文案。

至于小語種文案的更新,我可能會考慮使用 RPA 的方案去做。畢竟都是些規(guī)律性的操作,完全可以使用程序去自動化掉,節(jié)省自己的時間與精力。

后續(xù)看看這種方案做出來的小語種網站的數據情況到底如何,兩相對比一下(上一版本的小語種數據已經整理好了),就能知道個大概了。

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優(yōu)質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)