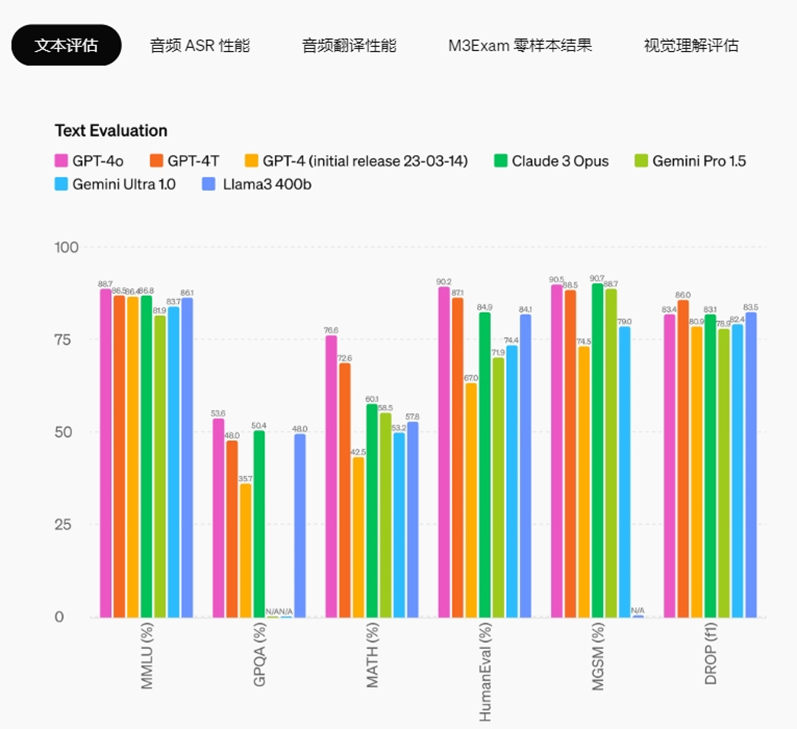

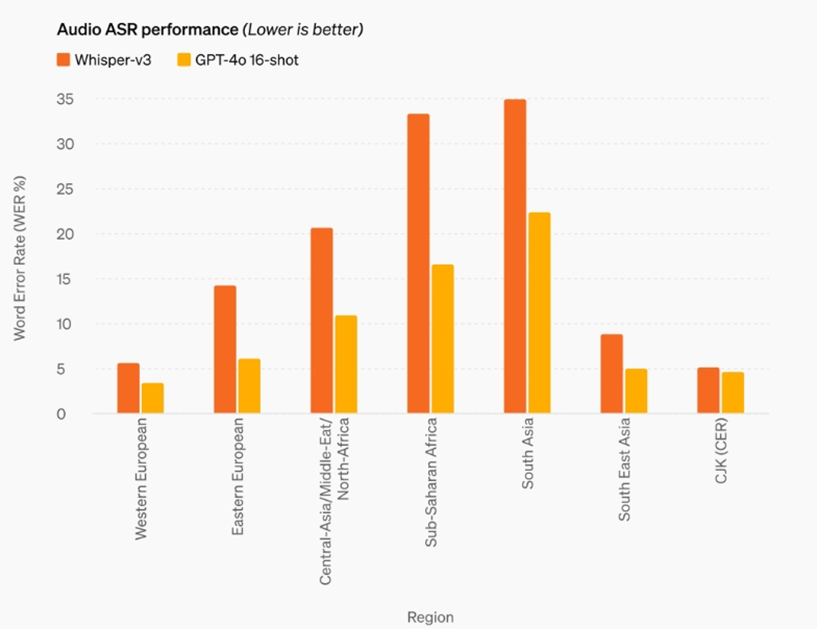

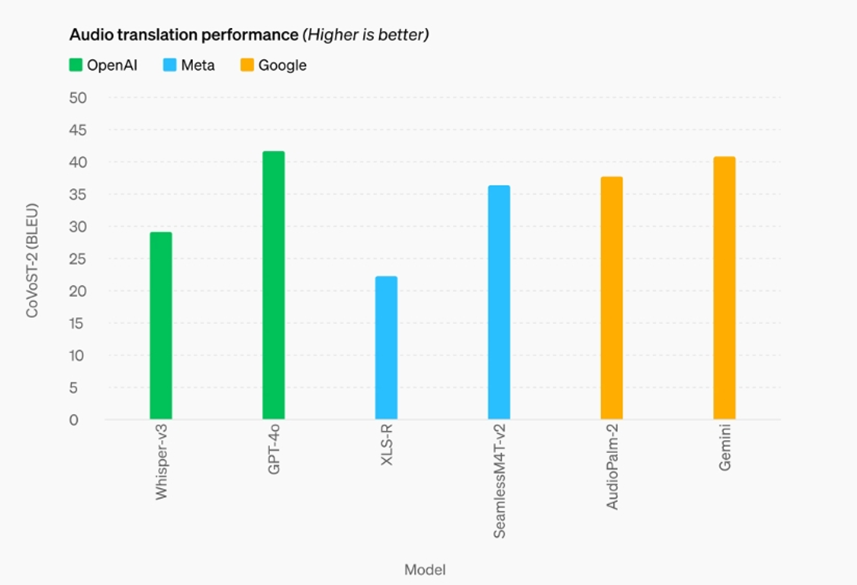

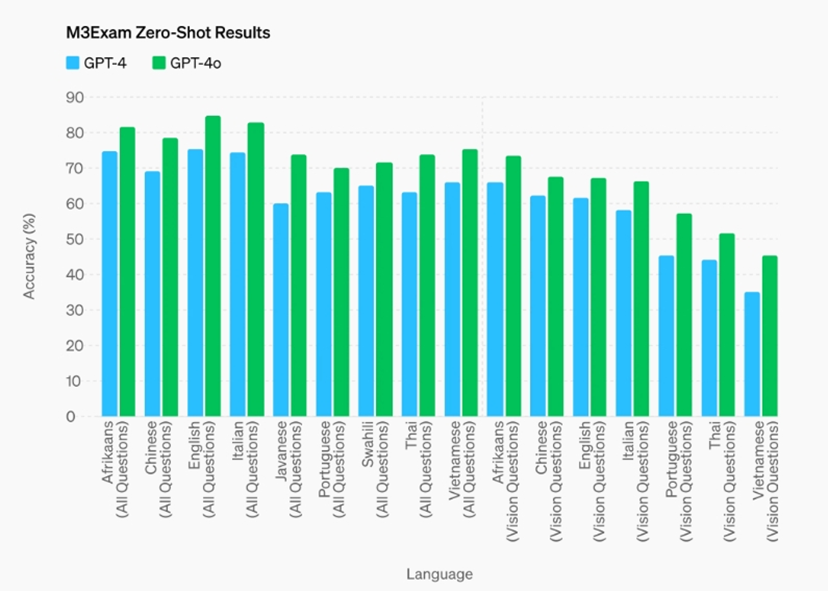

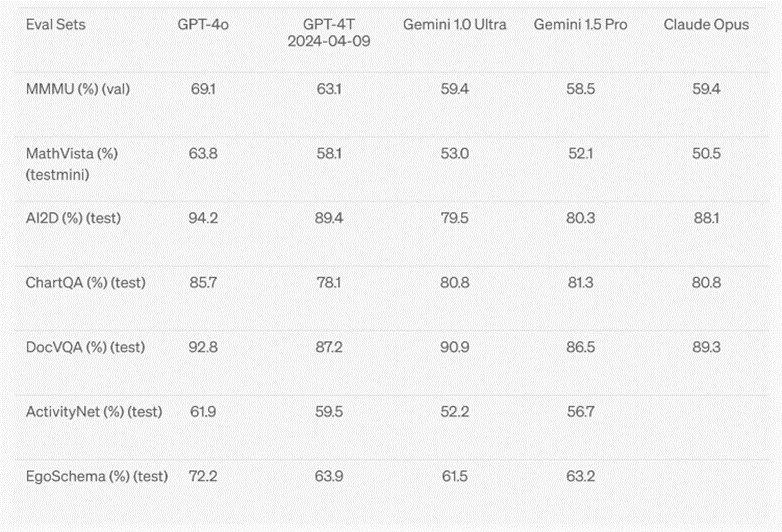

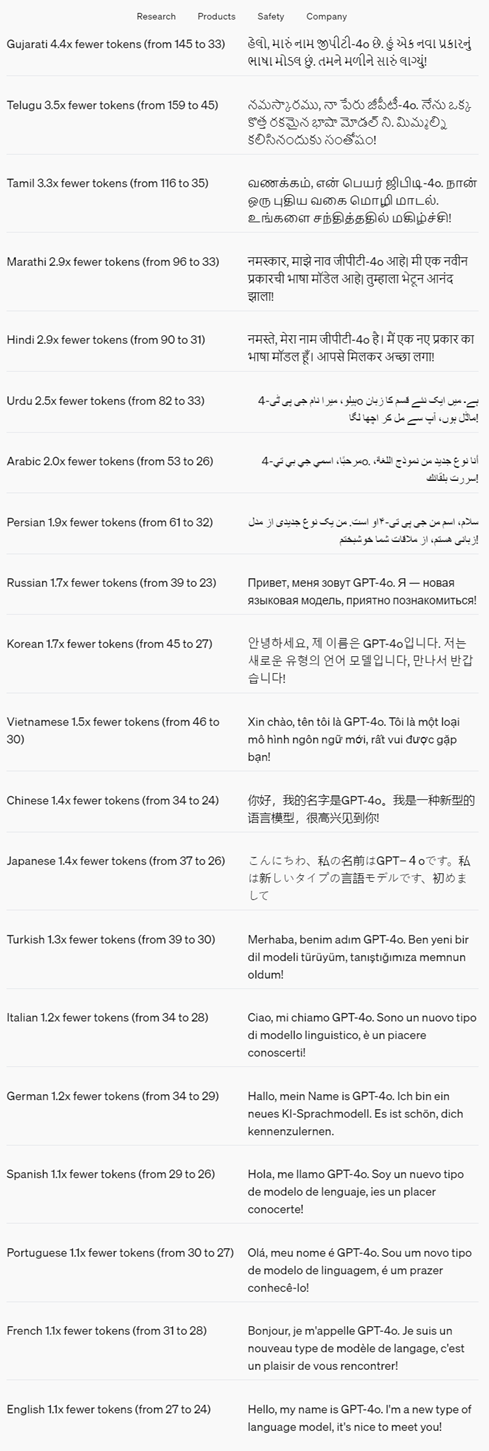

OpenAI 重磅資訊 發布免費大模型GPT-4o,? 更快、更智能、更安全 ????太平洋時間2024年5月13號上午10點,OpenAI春季發布會攜GPT-4o重磅來襲。OpenAI首席技術官 Mira Murati 表示,更新后的模型“速度更快”,并提高了“文本、視覺和音頻方面的功能”。它將免費向所有用戶開放,付費用戶將繼續“擁有免費用戶五倍的容量限制”。 圖片來源: https://twitter.com/OpenAI GPT-4o 中的“o”代表“omni”,指的是GPT-4o的多模態(全能),是朝著更自然的人機交互邁出的一步——它接受文本、音頻和圖像的任意組合作為輸入,并生成文本、音頻和圖像的任意組合輸出。 它可以在短至232毫秒的時間內響應音頻輸入,平均響應時間為320毫秒(接近人類對話中的響應時間)。雖然在英語文本和代碼方面,GPT-4o與GPT-4 Turbo的性能相當,但在非英語文本方面有了顯著改進,不僅速度更快,同時API費用降低了50%,是GPT-4 Turbo的一半與現有模型相比,GPT-4o在視覺和音頻理解方面表現尤為出色。 以下為新模型能力的展示 01 02 通過傳統的基準測試后發現, GPT-4o在文本、推理和編碼智能方面達到了GPT-4 Turbo級別性能, 同時在多語種、音頻和視覺能力方面創造了 新的里程碑 >>> 文本評估 推理能力增強——GPT-4o 在 0 次 COT MMLU(常識問題)上創下了 88.7% 的新高分。所有這些評估都是使用OpenAI的新的simple evals庫進行收集的。此外,在傳統的 5 次無 CoT MMLU 上,GPT-4o 創下了 87.2% 的新高。 (注:Llama3 400b仍在訓練中) ? >>>?音頻ASR性能 與Whisper-v3相比,GPT-4o顯著提高了所有語言的語音識別性能,特別是對于資源匱乏的語言。 >>>?音頻翻譯性能 GPT-4o在語音翻譯方面達到了新的最先進水平,并且在MLS基準測試中優于 Whisper-v3。 >>>?M3Exam 0-Shot結果 M3Exam-基準測試既是多語言評估也是視覺評估,包括其他國家標準化測試的多項選擇題,有時還包括圖形和圖表。在所有語言的基準測試中,GPT-4o表現得都比GPT-4更強(團隊省略了斯瓦希里語和爪哇語的視力結果,因為這些語言的視力問題只有 5 個或更少)。 ?如果想了解更多有關GPT-4的內容,點擊下面鏈接即可查看? https://www.semrush.com/blog/gpt-4/? >>>?視覺理解評估 在圖片視覺理解評估方面,GPT-4o在視覺感知基準測試上達到了最先進的性能。所有視覺評估都是0-shot,包括MMMU、MathVista和ChartQA。 03 以下 20 種語言被選為新標記器 在不同語言家族中壓縮的代表 04 GPT-4o通過各種技術來確保安全,采用了過濾訓練數據和通過后期訓練完善模型行為等技術。并且創建了新的安全系統,來為語言輸出提供防護措施。 另外,OpenAI還根據準備框架和自愿承諾,對GPT-4o進行了評估。在網絡安全、CBRN(化學、生物、輻射和核)風險、說服力和模型自主性方面的評估顯示,GPT-4o在任何一個類別中的風險評級均未到達中等以上。這一評估包括在整個模型訓練過程中進行一系列自動和人工評估:測試了模型在安全緩解措施前后的版本,使用了自定義的微調和提示,以更好地引發模型的能力。 除此之外,GPT-4o還經過了70多名外部專家在社會心理學、偏差和公平性、虛假信息等領域的大量外部紅隊測試,來確定新增模態會引入或放大的風險。利用這些經驗來完善安全干預措施,以提高與GPT-4o交互的安全性。 模型限制性示例 05 END

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)