今天被一個朋友問到,該怎么獲取競爭對手網站上所有開放的鏈接,干脆這篇文章簡單梳理一下。

其實要解決這個需要,我使用到的方法一般有三個,由易到難逐一介紹下。

最簡單的方法,自然是看網站的站點地圖。

直接在競爭對手域名后面加上 sitemap.xml 去訪問網站的站點頁面,就基本看到了這個網站所有的數據信息。

就拿 RankMath 這款 SEO 插件來說,它不僅提供了站點所有的索引鏈接數據,還將這些鏈接數據做了很好的層級劃分。

我們需要做的,就是將站點地圖上的數據信息復制下來,做下最簡單的數據格式清晰便可以保存下來了。

但是這種站點地圖方法,有時候有一點點缺點。

其一并不是所有網站都有站點地圖,可能原因是運營團隊真的沒有設置,當然也可能是因為運營團隊故意隱藏掉了。

其二是站點地圖上的鏈接,并不百分百包含網站的所有鏈接。

比如有些不打算讓搜索引擎收錄的頁面,可能在設置的時候便直接將其 noindex 了,于是這部分頁面便在站點地圖里面不可見。

所以為了獲取更全面的站點數據,我更傾向于使用一些 Site Audit 之類的工具。

比如業內在監控這塊做得非常棒的“尖叫青蛙”這款軟件,在抓取網站鏈接方面就做得很不錯。基本一個網站的根域名扔進去,軟件便可以很快速的將這個網站的所有鏈接全部抓出來。

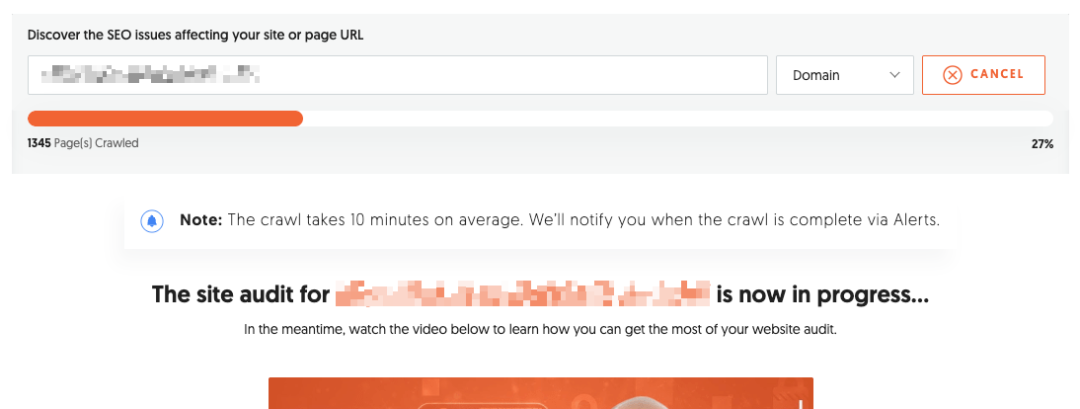

那除了這種桌面端軟件外,還有很多在線版的監控工具也非常好用,比如付費版本 Ahrefs 與 SEMRUSH 都提供網站檢測工具。

比如上圖是我使用 UberSuggest 這款 SEO 工具做競爭對手信息檢測,也完全可以實現我的需求。

且這些在線版的檢測工具有個好處,就是你設置外項目信息后,系統會持續關注競爭對手的所有操作。一旦競爭對手網站有任何異動,軟件都會在第一時間提醒你并給你生成相應報表。

其實上面這兩個方法等我們熟練掌握后,再去做競爭對手頁面鏈接梳理這樣的工作就非常輕而易舉了。

但是如果你的需求再復雜一點,比如一次性收集一千個競爭對手網站的鏈接信息,這就需要我們自己開發相應的信息抓取腳本了。

邏輯其實也簡單,類似于搜索引擎爬蟲的工作原理,不停在網站頁面上進行遞歸查找。

其實想要這樣的腳本,我們自己也不需要寫什么代碼,直接把自己的需求告訴 AI 工具,很快相應的解決方案便出來了。

當然上面這三個方法,都是常規的信息抓取手段了。至于不常規的,我們做正常業務的沒必要了解。

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)