關鍵字和內容可能是構建大多數搜索引擎優化策略的雙支柱,但它們遠非唯一重要的。

關鍵字和內容可能是構建大多數搜索引擎優化策略的雙支柱,但它們遠非唯一重要的。較少討論但同樣重要的——不僅對用戶而且對搜索機器人來說——是您網站的可發現性。

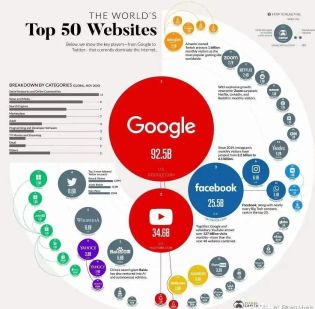

互聯網上有 19.3 億個網站,大約有500 億個網頁。對于任何人類團隊來說,這都太多了,因此這些機器人(也稱為蜘蛛)發揮著重要作用。

這些機器人通過跟蹤從網站到網站和頁面到頁面的鏈接來確定每個頁面的內容。這些信息被編譯成一個龐大的 URL 數據庫或索引,然后通過搜索引擎的算法進行排名。

導航和理解您的網站的這個兩步過程稱為抓取和索引。

作為一名 SEO 專業人士,您無疑已經聽說過這些術語,但為了清楚起見,讓我們對它們進行定義:

可抓取性是指這些搜索引擎機器人掃描和索引您的網頁的能力。

可索引性衡量搜索引擎分析您的網頁并將其添加到其索引中的能力。

正如您可能想象的那樣,這些都是 SEO 的重要組成部分。

如果您的網站的可抓取性較差,例如許多斷開的鏈接和死胡同,搜索引擎爬蟲將無法訪問您的所有內容,這會將其從索引中排除。

另一方面,可索引性至關重要,因為未編入索引的頁面不會出現在搜索結果中。Google 如何對未包含在其數據庫中的頁面進行排名?

抓取和索引過程比我們在這里討論的要復雜一些,但這是基本概述。

如果您正在尋找關于它們如何工作的更深入的討論,Dave Davies 有一篇關于爬行和索引的優秀文章。

如何改進抓取和索引

既然我們已經介紹了這兩個過程的重要性,那么讓我們來看看您的網站中影響抓取和索引的一些元素 - 并討論為它們優化您的網站的方法。

1.提高頁面加載速度

有數十億個網頁要編目,網絡蜘蛛不必整天等待您的鏈接加載。這有時稱為爬網預算。

如果您的網站未在指定的時間范圍內加載,它們將離開您的網站,這意味著您將保持未抓取和未編入索引。正如您可以想象的那樣,這不利于 SEO。

因此,定期評估您的頁面速度并盡可能改進它是一個好主意。

您可以使用 Google Search Console 或Screaming Frog等工具來檢查您網站的速度。

如果您的網站運行緩慢,請采取措施緩解問題。這可能包括升級您的服務器或托管平臺、啟用壓縮、縮小 CSS、JavaScript 和 HTML,以及消除或減少重定向。

通過查看您的Core Web Vitals報告,找出導致加載時間變慢的原因。如果您想了解有關您的目標的更詳細信息,尤其是從以用戶為中心的角度來看,Google Lighthouse是一個您可能會發現非常有用的開源工具。

2、加強內鏈結構

良好的網站結構和內部鏈接是成功的 SEO 策略的基本要素。搜索引擎難以抓取雜亂無章的網站,這使得內部鏈接成為網站可以做的最重要的事情之一。

但不要只相信我們的話。以下是Google 的搜索倡導者 John Mueller對此的評價:

“內部鏈接對于 SEO 來說非常重要。我認為這是您可以在網站上做的最重要的事情之一,以引導 Google 并引導訪問者訪問您認為重要的頁面。”

如果您的內部鏈接很差,您還會面臨孤立頁面或未鏈接到您網站的任何其他部分的頁面的風險。由于沒有任何內容指向這些頁面,因此搜索引擎找到它們的唯一方法是從您的站點地圖中。

要消除此問題以及其他由結構不良引起的問題,請為您的站點創建一個合乎邏輯的內部結構。

您的主頁應鏈接到金字塔下方頁面支持的子頁面。然后,這些子頁面應該具有感覺自然的上下文鏈接。

另一件需要注意的事情是斷開的鏈接,包括那些在 URL 中有拼寫錯誤的鏈接。當然,這會導致鏈接斷開,從而導致可怕的404 錯誤。換句話說,找不到頁面。

這樣做的問題是損壞的鏈接無濟于事,并且正在損害您的可抓取性。

仔細檢查您的網址,尤其是在您最近進行過網站遷移、批量刪除或結構更改的情況下。并確保您沒有鏈接到舊的或已刪除的 URL。

內部鏈接的其他最佳實踐包括擁有大量可鏈接內容(內容始終為王),使用錨文本而不是鏈接圖像,以及在頁面上使用“合理數量”的鏈接(無論這意味著什么)。

哦,是的,并確保您使用跟隨鏈接作為內部鏈接。

3. 將您的站點地圖提交給 Google

如果有足夠的時間,并且假設您沒有告訴它不要這樣做,Google 會抓取您的網站。這很好,但在您等待時,它對您的搜索排名沒有幫助。

如果您最近對您的內容進行了更改并希望 Google 立即了解它,最好將站點地圖提交到Google Search Console。

站點地圖是位于根目錄中的另一個文件。它作為搜索引擎的路線圖,直接鏈接到您網站上的每個頁面。

這有利于可索引性,因為它允許 Google 同時了解多個頁面。爬蟲可能必須遵循五個內部鏈接才能發現深層頁面,但通過提交 XML 站點地圖,它可以通過一次訪問您的站點地圖文件找到您的所有頁面。

如果您有一個深度網站、經常添加新頁面或內容,或者您的網站沒有良好的內部鏈接,那么將您的站點地圖提交給 Google 尤其有用。

4. 更新 Robots.txt 文件

您可能希望為您的網站創建一個robots.txt文件。雖然不是必需的,但 99% 的網站將其用作經驗法則。如果您不熟悉它,它是您網站根目錄中的純文本文件。

它告訴搜索引擎爬蟲您希望他們如何爬取您的網站。它的主要用途是管理機器人流量并防止您的網站因請求而過載。

這在可抓取性方面派上用場的地方是限制谷歌抓取和索引的頁面。例如,您可能不希望 Google 目錄中的目錄、購物車和標簽等頁面。

當然,這個有用的文本文件也會對您的可抓取性產生負面影響。非常值得查看您的 robots.txt 文件(如果您對自己的能力沒有信心,請讓專家這樣做),看看您是否無意中阻止了爬蟲訪問您的網頁。

robots.text 文件中的一些常見錯誤包括:

Robots.txt 不在根目錄中。

通配符使用不當。

robots.txt 中沒有索引。

被阻止的腳本、樣式表和圖像。

沒有站點地圖網址。

5. 檢查你的規范化

規范標簽將來自多個 URL 的信號整合到一個規范 URL 中。這可能是一種有用的方法,可以告訴 Google 索引您想要的頁面,同時跳過重復和過時的版本。

但這為流氓規范標簽打開了大門。這些是指不再存在的頁面的舊版本,導致搜索引擎索引錯誤的頁面并使您的首選頁面不可見。

要消除此問題,請使用 URL 檢查工具掃描惡意標簽并將其刪除。

如果您的網站面向國際流量,即,如果您將不同國家的用戶引導至不同的規范頁面,則您需要為每種語言設置規范標簽。這可確保您的網頁以您網站使用的每種語言編入索引。

6. 進行現場審核

既然您已經執行了所有這些其他步驟,您還需要做最后一件事來確保您的網站針對抓取和索引進行了優化:網站審核。首先要檢查 Google 為您的網站編制索引的頁面百分比。

檢查您的索引率

您的索引率是 Google 索引中的頁數除以我們網站上的頁數。

您可以通過轉到“頁面”選項卡并從 CMS 管理面板檢查網站上的頁面數,從 Google Search Console 索引中找出?google 索引中有多少頁。

您的網站很有可能會有一些您不想編入索引的頁面,因此這個數字可能不會是 100%。但如果可轉位率低于 90%,那么您就有需要調查的問題。

您可以從 Search Console 獲取未編入索引的網址并對其進行審核。這可以幫助您了解導致問題的原因。

Google Search Console 中包含的另一個有用的站點審核工具是URL 檢查工具。這使您可以查看 Google 蜘蛛看到的內容,然后您可以將其與真實網頁進行比較,以了解 Google 無法呈現的內容。

審核新發布的頁面

每當您將新頁面發布到您的網站或更新您最重要的頁面時,您都應該確保它們被編入索引。進入 Google Search Console 并確保它們都顯示出來。

如果您仍然遇到問題,審核還可以讓您深入了解您的 SEO 策略的其他部分有哪些不足,所以這是雙贏的。使用免費工具擴展您的審計流程,例如:

Screaming Frog

Semrush

Ziptie

Oncrawl

Lumar

7.檢查低質量或重復的內容

如果 Google 不認為您的內容對搜索者有價值,它可能會認為它不值得索引。眾所周知,這種稀薄的內容可能是寫得不好的內容(例如,充滿了語法錯誤和拼寫錯誤)、不是您的網站獨有的樣板內容,或者沒有關于其價值和權威的外部信號的內容。

要找到這一點,請確定您網站上的哪些頁面沒有被索引,然后查看它們的目標查詢。他們是否為搜索者的問題提供了高質量的答案?如果沒有,請更換或刷新它們。

重復的內容是機器人在抓取您的網站時可能會掛斷的另一個原因。基本上,發生的情況是您的編碼結構混淆了它,它不知道要索引哪個版本。這可能是由會話 ID、冗余內容元素和分頁問題等引起的。

有時,這會在 Google Search Console 中觸發警報,告訴您 Google 遇到的 URL 比它認為的要多。如果您沒有收到,請檢查您的抓取結果中是否存在重復或缺失的標簽,或者帶有額外字符的 URL,這些字符可能會給機器人帶來額外的工作。

通過修復標簽、刪除頁面或調整 Google 的訪問權限來糾正這些問題。

8. 消除重定向鏈和內部重定向

隨著網站的發展,重定向是一種自然的副產品,將訪問者從一個頁面引導到更新或更相關的頁面。但是,雖然它們在大多數網站上都很常見,但如果您處理不當,您可能會無意中破壞您自己的索引。

創建重定向時可能會犯幾個錯誤,但最常見的錯誤之一是重定向鏈。當點擊的鏈接和目的地之間有多個重定向時,就會發生這種情況。谷歌并不認為這是一個積極的信號。

在更極端的情況下,您可能會啟動一個重定向循環,其中一個頁面重定向到另一個頁面,另一個頁面指向另一個頁面,依此類推,直到它最終鏈接回第一個頁面。換句話說,您創建了一個永無止境的循環,無處可去。

使用 Screaming Frog、Redirect-Checker.org或類似工具檢查您網站的重定向。

9.修復斷開的鏈接

同樣,斷開的鏈接也會嚴重破壞您網站的可抓取性。您應該定期檢查您的網站以確保您沒有損壞的鏈接,因為這不僅會損害您的 SEO 結果,還會讓人類用戶感到沮喪。

您可以通過多種方式在您的網站上找到損壞的鏈接,包括手動評估您網站上的每個鏈接(頁眉、頁腳、導航、文本等),或者您可以使用 Google Search Console、Analytics 或Screaming Frog 發現 404 錯誤。

找到損壞的鏈接后,您可以通過三個選項來修復它們:重定向它們(請參閱上面的警告部分)、更新它們或刪除它們。

10. 現在索引

IndexNow 是一個相對較新的協議,它允許通過 API 在搜索引擎之間同時提交 URL。它通過提醒搜索引擎有關新 URL 和您網站的更改來像提交 XML 站點地圖的超級充電版本一樣工作。

基本上,它所做的是預先為爬蟲提供了通往您網站的路線圖。他們會帶著他們需要的信息進入您的網站,因此無需經常重新檢查站點地圖。與 XML 站點地圖不同,它允許您通知搜索引擎有關非 200 狀態代碼頁面的信息。

實現它很容易,只需要您生成一個 API 密鑰,將其托管在您的目錄或其他位置,并以推薦的格式提交您的 URL。

包起來

到目前為止,您應該對網站的可索引性和可抓取性有一個很好的了解。您還應該了解這兩個因素對您的搜索排名有多重要。

如果 Google 的蜘蛛可以抓取您的網站并將其編入索引,那么無論您使用多少關鍵字、反向鏈接和標簽,您都不會出現在搜索結果中。

這就是為什么必須定期檢查您的網站是否存在任何可能會阻礙、誤導或誤導機器人的原因。

因此,為自己準備一套好的工具并開始吧。勤奮并注意細節,你很快就會讓谷歌蜘蛛像蜘蛛一樣涌入你的網站。

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)